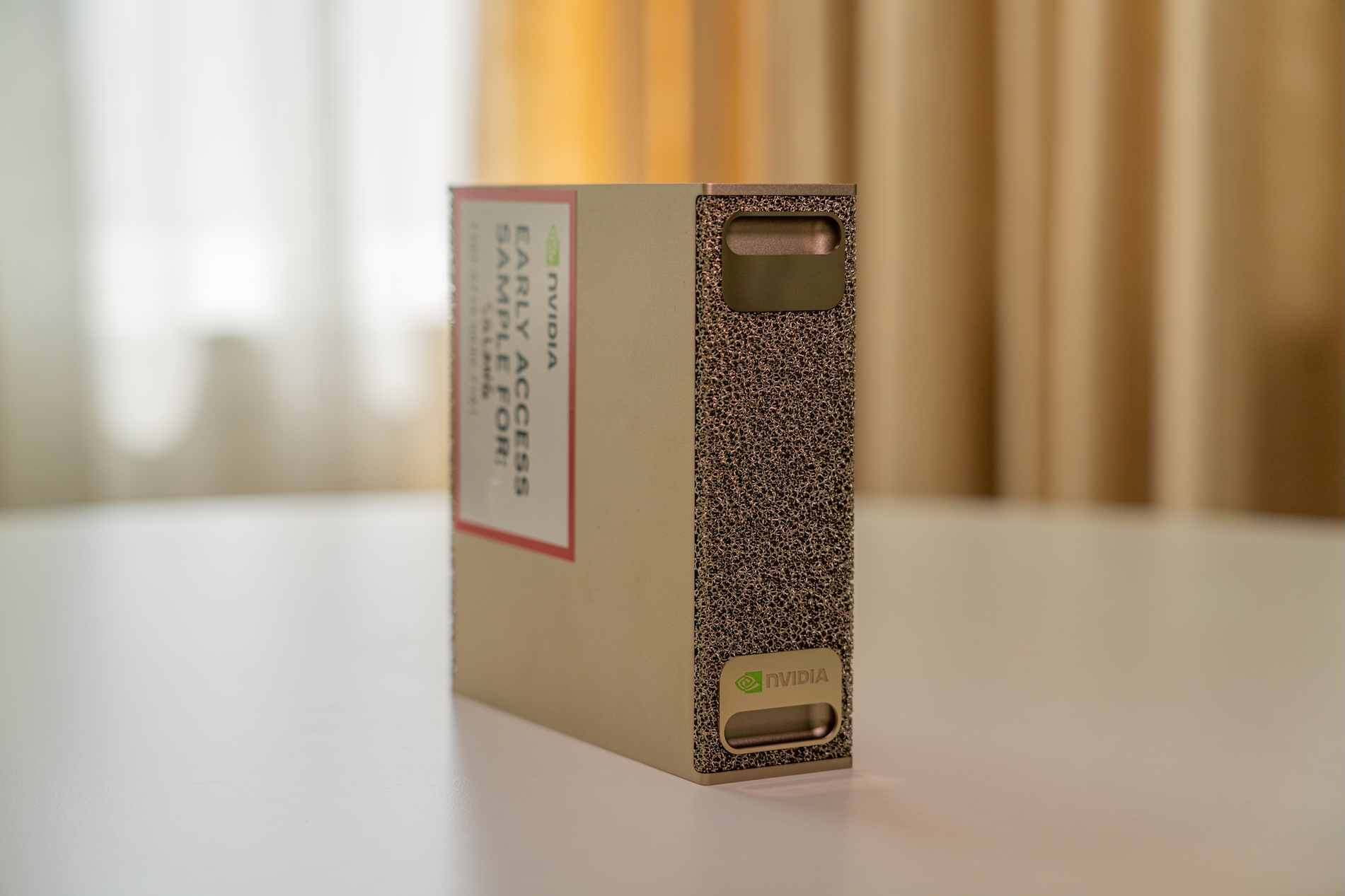

多亏 NVIDIA 的早期访问计划,我们有机会上手 NVIDIA DGX™ Spark。这是一款非同寻常的系统,因为 NVIDIA 很少推出如此紧凑的一体机,将超级计算级性能浓缩到桌面工作站形态。

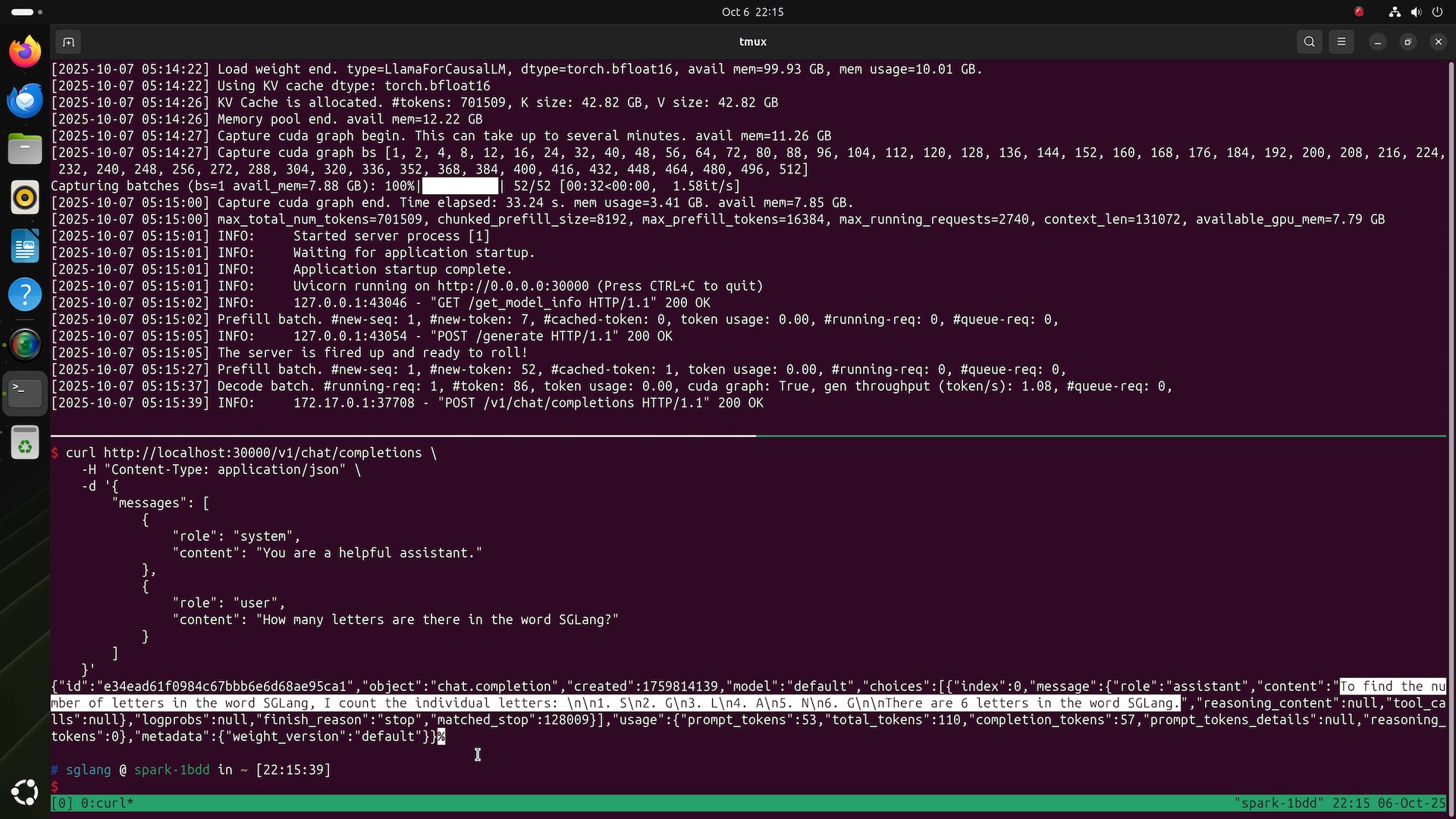

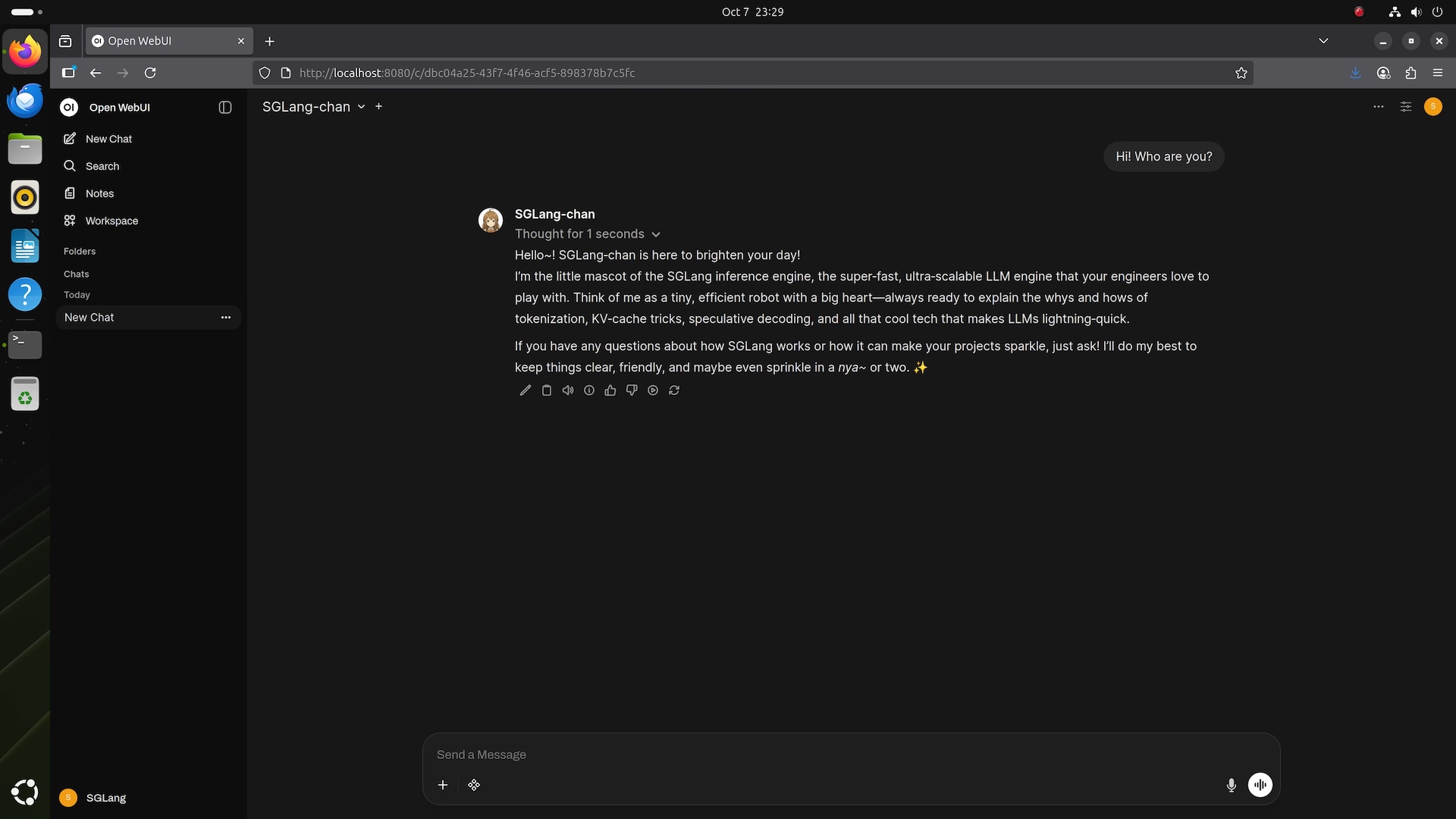

过去一年,SGLang 在数据中心领域迅速扩展开发者社区,以出色推理性能闻名。它成功部署 DeepSeek,使用 Prefill-decode Disaggregation (PD) 和 Expert Parallelism (EP),运行于96 张 NVIDIA H100 GPU 集群和最新的GB200 NVL72 系统,不断突破大规模推理性能和开发者生产力极限。

受 DGX Spark 启发,SGLang 首次从数据中心扩展到消费市场,将成熟推理框架直接带给全球开发者与研究者。本评测将细致审视这款精美设备,从外观美学到性能表现与应用场景。

另请查看我们的视频评测 此处。

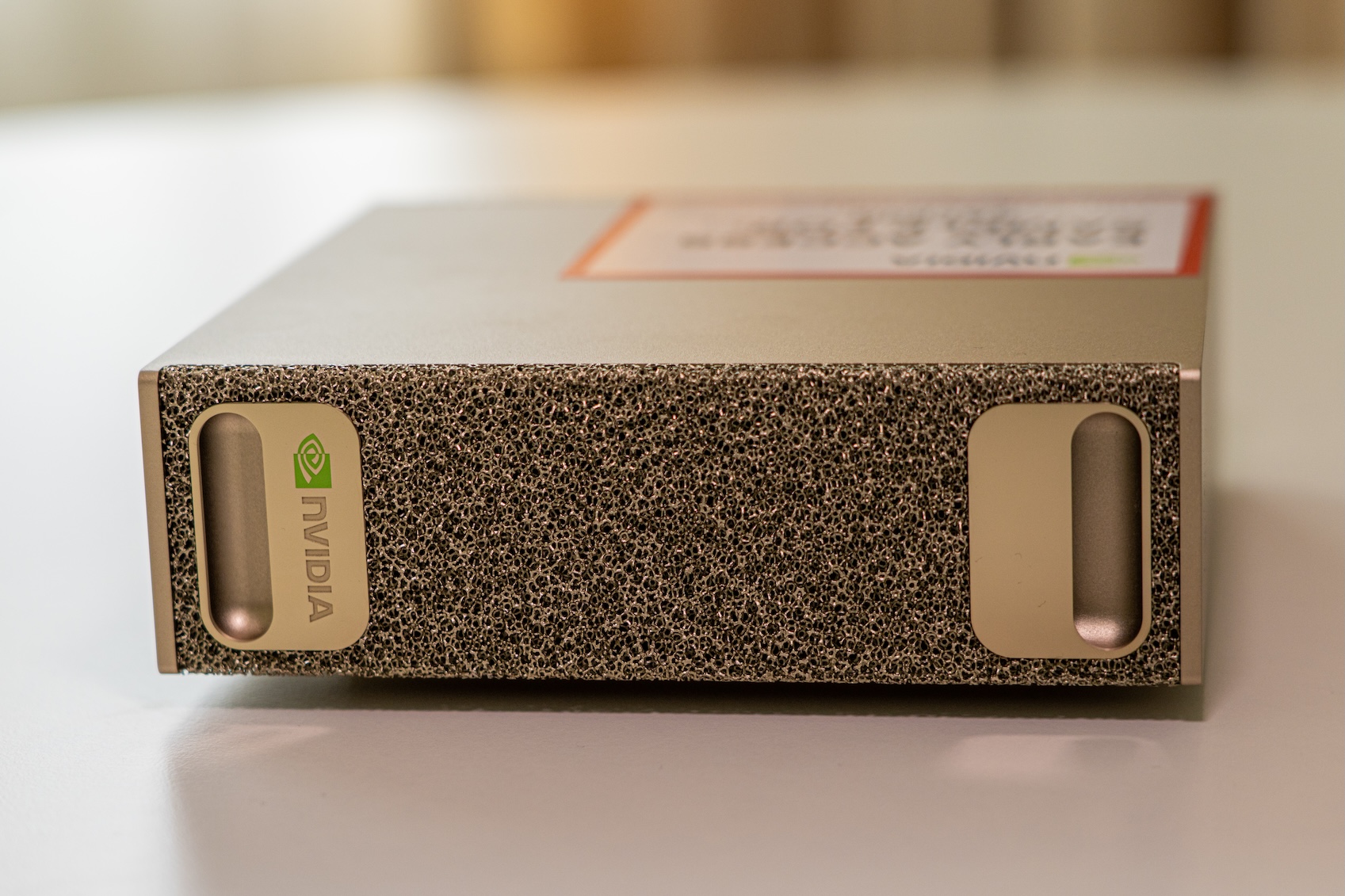

外观设计

DGX Spark 是工程美学的杰作。全金属机身采用香槟金色拉丝饰面,前后面板使用金属泡沫工艺, reminiscent of NVIDIA DGX A100 和 H100 的设计。

后部接口丰富:电源键、四个 USB-C 接口(最左侧支持最高 240 W 功率输出)、HDMI 接口、10 GbE RJ-45 以太网口,以及由 NVIDIA ConnectX-7 NIC 驱动的两个 QSFP 接口(最高 200 Gbps)。这些接口允许两台 DGX Spark 互联,运行更大 AI 模型。

USB Type-C 供电设计别具一格,其他桌面机鲜见。相比 Mac Mini 或 Mac Studio 的 C5/C7 电源插头,USB-C 让电源外置,腾出内部冷却空间。但需注意避免意外拔线。

硬件规格

硬件方面,DGX Spark 在紧凑体积和功耗下表现出色。核心是专为本机设计的 NVIDIA GB10 Grace Blackwell Superchip,集成 10 个 Cortex-X925 性能核和 10 个 Cortex-A725 效率核,共 20 个 CPU 核心。

GPU 端,GB10 提供最高 1 PFLOP 稀疏 FP4 张量性能,AI 能力介于 RTX 5070 和 5070 Ti 之间。亮点是128 GB 一致性统一系统内存,CPU 与 GPU 无缝共享,避免系统到 VRAM 数据传输开销。借助双 QSFP 以太网口(聚合 200 Gb/s 带宽),两台设备可组成小型集群,支持更大模型分布式推理。NVIDIA 称,两台互联 DGX Spark 可处理最高 4050 亿参数 FP4 模型。

唯一短板是内存带宽,统一内存为 LPDDR5x,最高 273 GB/s,CPU/GPU 共享,后续测试证实这是 AI 推理主要瓶颈。尽管如此,128 GB 内存让它能运行多数桌面系统无法负载的大模型。

性能测试

我们使用 SGLang 和 Ollama 在 DGX Spark 上基准测试多款开源大语言模型。结果显示,它能加载运行超大模型如 GPT-OSS 120B 和 Llama 3.1 70B,但更适合原型开发与实验,而非生产环境。对于小型模型,尤其启用批处理时,表现卓越。

测试方法

⚠️ 注意:软件支持尚处早期,基准结果可能随未来更新而过时。

测试设备

- NVIDIA DGX Spark

- NVIDIA RTX PRO™ 6000 Blackwell Workstation Edition

- NVIDIA GeForce RTX 5090 Founders Edition

- NVIDIA GeForce RTX 5080 Founders Edition

- Apple Mac Studio (M1 Max, 64 GB 统一内存)

- Apple Mac Mini (M4 Pro, 24 GB 统一内存)

基准模型

使用 SGLang 和 Ollama 评估多款开源 LLM:

| 框架 | 批大小 | 模型 & 量化 |

|---|---|---|

| SGLang | 1–32 | Llama 3.1 8B (FP8) Llama 3.1 70B (FP8) Gemma 3 12B (FP8) Gemma 3 27B (FP8) DeepSeek-R1 14B (FP8) Qwen 3 32B (FP8) |

| Ollama | 1 | GPT-OSS 20B (MXFP4) GPT-OSS 120B (MXFP4) Llama 3.1 8B (q4_K_M / q8_0) Llama 3.1 70B (q4_K_M) Gemma 3 12B (q4_K_M / q8_0) Gemma 3 27B (q4_K_M / q8_0) DeepSeek-R1 14B (q4_K_M / q8_0) Qwen 3 32B (q4_K_M / q8_0) |

另测试部分模型的 speculative decoding (EAGLE3) with SGLang,排除超出内存容量模型。

测试结果

完整结果见 此处。

整体性能

DGX Spark 在体积与功耗下工程出色,但原始性能不及独立 GPU 系统。例如,Ollama GPT-OSS 20B (MXFP4) 下,Spark 达 2,053 tps prefill / 49.7 tps decode,而 RTX Pro 6000 Blackwell 达 10,108 tps / 215 tps,约快 4 倍;RTX 5090 也达 8,519 tps / 205 tps。统一 LPDDR5x 带宽是主要限制。

小型模型如 Llama 3.1 8B,SGLang batch 1 下达 7,991 tps prefill / 20.5 tps decode,batch 32 时线性扩展至 7,949 tps / 368 tps,批处理效率优秀。

统一内存优势

128 GB 一致性统一内存 是核心亮点,CPU/GPU 共享地址空间。大模型如 Llama 3.1 70B、Gemma 3 27B 或 GPT-OSS 120B 可直接加载,无传输开销。Llama 3.1 70B (FP8) 达 803 tps prefill / 2.7 tps decode,桌面级惊艳。适合原型开发、模型实验、边缘 AI 研究。

投机解码加速

启用 SGLang EAGLE 3 投机解码,小模型“draft”预生成令牌,大模型并行验证,多模型端到端吞吐加速高达 2 倍,如 Llama 3.1 8B。软件优化有效缓解带宽瓶颈。

效率与散热

高负载下无热节流,如 SGLang DeepSeek-R1 14B (FP8) batch 8 达 2,074 tps / 83.5 tps,风扇噪音与温度稳定,归功金属泡沫冷却与优化供电。USB-C 240 W 输入 + 外置 PSU 提供更大热裕度,优于 Mac Mini/Studio。

总结

DGX Spark 非为与全尺寸 Blackwell/Ada GPU 正面对抗,而是将 DGX 体验浓缩为开发者友好紧凑形态。理想用于:

- 模型原型与实验

- 轻量设备端推理

- 内存一致 GPU 架构研究

它是一款精美工程化的迷你超级计算机,以易用性换取原始性能。